Chaos Engineering 🔗

🧪 Tests

🐒 Si vous voulez prouver qu’un système distribué est tolérant aux pannes, vous devrez essayer de le mettre en panne, en production. Que se passe-t-il si le reverse proxy tombe ? Si une région AWS entière est indisponible ? Les humains ont tendance à esquiver inconsciemment les véritables scénarios problématiques, il faut donc permettre à un robot, le Chaos Monkey, de provoquer des pannes aléatoires en injectant des données erronnées, en ajoutant de la latence ou en coupant des machines. Complétement idiot ? Non, cette technique que l’on appelle Chaos Engineering est utilisée par toutes les organisations qui se préparent sérieusement à l’inattendu. Shit happens.

📝 La manière de mener de telles campagnes de test est assez cadrée. Le papier qui en parle est assez court, je ne ferai que de le paraphraser en le résumant.

SOURCE

A. Basiri et al., “Chaos Engineering,” in IEEE Software, vol. 33, no. 3, pp. 35-41, May-June 2016, DOI:10.1109/MS.2016.60.

📄 Lien public

DOIs:

10.48550/arXiv.1702.05843

STADS: Software Testing as Species Discovery 🔗

🧪 Tests

🕵️ Comment savoir si la recherche de bugs sur un système touche à sa fin ? Avec des entrées complexes, il est manifestement impossible de tout essayer par bruteforce. Le fuzzing consiste à envoyer des données ayant un maximum de chances de provoquer une erreur dans un système. C’est une branche du random testing. Cependant même avec un bon fuzzer, les test peuvent être longs, voire infiniment longs.

🪹 On sait depuis plusieurs décennies qu’un fuzzer remontera des bugs selon un courbe logarithmique : plus le temps passe, moins il y aura de bugs découverts. Comment savoir quand l’énergie consommée par le fuzzer sera plus coûteuse que le retour sur investissement potentiel ?

🦋 Un réponse prometteuse vient de la zoologie, qui a le même genre de problèmes : comment savoir combien d’espèces restent à découvrir sur une zone donnée ? Une formule mathématique permet d’extrapoler le nombre d’espèces restant à découvrir (vues 0 fois) à partir de celles vues une fois et de celles vues deux fois.

🪲 Est-ce applicable aux bugs et autres vulnérabilités ? Oui, mais avec prudence car s’il est facile de savoir si l’on a 2 occurrence du même animal, il est compliqué de dire si deux bugs sont du même type ou non. Cependant la méthode offre des résultats intéressants.

SOURCE

Marcel Böhme. 2018. STADS: Software Testing as Species Discovery. ACM Trans. Softw. Eng. Methodol. 27, 2, Article 7 (April 2018), 52 pages. DOI:10.1145/3210309

📄 Lien public

DOIs:

10.48550/arXiv.1803.02130

On the notion of object 🔗

🔣 Science des Langages

📦 Le concept d’objet dans les langages orientés-objet est difficile à définir. Les divergences entre les différentes “saveurs” d’orienté-objet et le drama entre auteurs explique en partie le problème. Les américains tendent à y voir seulement un mécanisme de modélisation efficace, tandis que les européens tendent à rechercher une certaine esthétique philosophique dépassant la stricte nécessité technique.

🏺 Pour comprendre ce qu’est un objet, il faut étudier la notion sous plusieurs angles, n’ayant pas tous un rapport direct à l’informatique, nous serions même parfois plus proches des mathématiques, de la psychologie et de la philosophie.

😶🌫️ Un objet peut être vu comme une substance attachée à une identité permettant de le distinguer des autres. Toujours dans la même veine ontologique, un objet peut aussi être défini comme l’inverse d’une valeur. Cette dernière est éternelle, immuable, universelle et sans identité. Hélas la plupart des langages ne l’entendent pas ainsi et la moindre valeur, même une primitive, est alors un objet comme un autre. En informatique, “Objet” est un terme équivoque, zut.

🛡️ L’objet peut aussi être défini comme l’inverse des fonctions. La fonction n’a aucune mémoire, elle est pure et sans effet de bord. L’objet stocke un état. Mais ce serait insuffisant car les objets exposent des opérations qui protègent l’état qu’ils contiennent contre l’écriture de valeurs invalides. Parce qu’il n’est pas référentiellement transparent, l’objet est une abstraction, masquant une partie de la complexité qu’il contient derrière une façade : son interface. Hélas encore une fois, le concepte d’abstraction de données et celui d’objet ne sont pas identiques et ne se recouvrent pas complètement. Caramba, encore raté !

🔢 Essayons alors la définition purement technique : un objet est un dictionnaire de propriétés, chacune étant un tableau d’octets que l’on regarde à travers des lunettes qui permettent de l’interpréter. Ce point de vue est probablement le plus exact, mais aussi le plus insatisfaisant, sauf peut-être pour un développeur Javascript.

➗ Essayons alors les mathématiques. Un objet est alors une machine à états finis, possédant des fonctions transformant un état en un autre. L’objet peut être décrit comme un tuple à 4 éléments : son identité, son type, son état actuel et l’ensemble des identifiants y faisant référence. L’identité est immuable, le type l’est souvent, l’état peut varier selon les règles qu’impose le type. Le type peut parfaitement imposer à l’état d’un objet une totale immutabilité, ce qui le rend référentiellement transparent. Les identifiants quant à eux sont un tableau associant des noms à un objet donné.

🧑🏫 Pris isolément, aucun de ces points de vue n’a la moindre utilité pratique au développeur. Tous ces points de vue sont complémentaires et offrent un éclairage complet sur un phénomène bien plus complexe qu’il n’y paraît. L’auteur cite Marvin Minsky : nous ne comprenons rien tant que nous ne l’avons pas appris de plusieurs manières.

SOURCE

Antero Taivalsaari. 1993. On the notion of object. J. Syst. Softw. 21, 1 (April 1993), 3–16. DOI:10.1016/0164-1212(93)90013-N

DOIs:

10.1016/0164-1212(93)90013-N

Microservices tenets: Agile approach to service development and deployment 🔗

🥸 Les microservices ne sont qu’une variante du style Service-Oriented Architecture (SOA). Ils n’ont rien de révolutionnaire. Les technologies ont changé, il est plus “cool” de dire qu’on fait du microservices, mais les contraintes architecturales sont rigoureusement les mêmes.

☁️ La plupart des principes qui gouvernent les microservices sont des reformulations des principes SOA. Le papier argumente fortement dans ce sens. Les microservices n’ont comme vraie nouveauté que les exigences propres à l’environnement cloud-native.

🪤 L’auteur n’évoque pas les pièges mortels du préfixe “micro”, qui n’agrémente pas de manière heureuse le mot de “service”, largement suffisant et ayant fait ses preuves.

SOURCE

Zimmermann, Olaf. (2016). Microservices tenets: Agile approach to service development and deployment. Computer Science - Research and Development. 32. DOI:10.1007/s00450-016-0337-0.

📄 Lien public

DOIs:

10.1007/s00450-016-0337-0

Extending ordinary inheritance schemes to include generalization 🔗

🔣 Science des Langages

🧠 Le mécanisme cognitif que l’on nomme spécialisation nous est familier en programmation. Si un canard est un animal, alors la plupart des langages permettent de dériver un classe canard de la super-classe animal. Le chemin inverse se nomme la généralisation. Aucun langage courant ne propose de mécanisme permettant de créer une super-classe en masquant des propriétés d’une ou plusieurs sous-classes.

🌱 L’auteur propose de créer un tel mécanisme. Sa réfléxion est restée purement théorique, cependant il s’agit probablement de la graine qui donnera ultérieurement le mécanisme d’interface explicite, présent notamment en C# ou en PHP. Une interface explicite peut être déclarée après les classes qu’elle doit unir.

SOURCE

Pedersen, Claus. (1989). Extending ordinary inheritance schemes to include generalization. ACM SIGPLAN Notices. 24. 407-417. DOI:10.1145/74878.74920.

📄 Lien public

DOIs:

10.1145/74878.74920

Looking for a place to hide: a study of social loafing in agile teams 🔗

🧠 Psychologie

😴 Les projets étudiants sont une répétition générale du monde du travail : plus le groupe est nombreux, plus les passagers clandestins pourront délibérément exploiter les autres sans se faire prendre. Le phénomène que je décris ne doit pas être confondu avec l’organisation sous-optimale d’une équipe ou les différences de niveau entre ses membres, qui ne sont pas des pertes de productivité intentionnelles mais accidentelles. Ce phénomène est appelé flânerie sociale, social loafing dans la langue de Chesterton.

😶🌫️ Les méthodes agiles interdisent de mesurer les performances individuelles ou d’affecter des tâches à quiconque. L’équipe est un atome (Whole Team & Collective Ownership en eXtreme Programming). On pourrait s’attendre à voir les parasites se greffer aux équipes agiles comme la misère sur le monde. Les deux cas étudiés par les chercheurs semblent montrer qu’il n’en est rien. Au contraire, les indicateurs individuels semblent plus faciles à “hacker” par les paresseux que les relations humaines d’une équipe agile.

⚠️ L’échantillon est plus que maigre, nous connaissons probablement tous des contre-exemples de cela, aussi ce résultat doit être pris avec prudence.

SOURCE

McAvoy, John and Tom Butler. “Looking for a place to hide: a study of social loafing in agile teams.” European Conference on Information Systems (2006).

📄 Lien public

Better, Not More Expensive, Faster? The Perceived Effects of Pair Programming in Survey Data 🔗

#️⃣ Façonnage de code

🎓 Le Pair Programming divise. Il fallait donc une revue de littérature pour trancher. Sa première conclusion est que nous manquons de données sur des vraies équipes, la plupart des études étant réalisées sur des étudiants. L’hypothèse d’une augmentation massive des coûts, abondamment soutenue par les managers, semble réfutée, même si des études de cas montrent que certaines équipes n’arrivent pas à être efficaces en pair programming. Le pair programming coûte en productivité, mais de manière modérée, ce qui est compensé par les bénéfices de la pratique.

💎 Quels sont ces bénéfices ? L’augmentation de la qualité est réelle, même si les développeurs la perçoivent bien supérieure à ce qu’elle est réellement dans les mesures. La satisfaction des développeurs augmente significativement, ce qui pourrait expliquer une si faible baisse de productivité. Un développeur motivé “glande” moins. Les bénéfices du pair programming semblent amplifiés par les autres pratiques d’XP, mais avec un faible niveau de preuves.

SOURCE

Parsons, D., Hokyoung Ryu and Ramesh Lal. “Better, Not More Expensive, Faster? The Perceived Effects of Pair Programming in Survey Data.” ACIS (2008).

📄 Lien public

A systematic literature review of literature reviews in software testing 🔗

🧪 Tests

🗜️ La littérature sur les tests est abondante, tant en matière d’études primaires que secondaires. Aucune étude tertiaire, effectuant la revue de littérature des revues de littératures, n’existait encore à propos des tests. C’est chose faite et les enseignements sont intéressants.

1️⃣ Première leçon : à l’exception du marronnier MBSE, aucun sujet populaire sur Google n’a fait l’objet de beaucoup d’études secondaires, et inversement. On retrouve ici le vieux sujet du décalage entre praticiens et chercheurs.

2️⃣ Seconde leçon : les études secondaires sur les tests foisonnent à partir de 2009. Cela montre un véritable intérêt de la communauté de recherche pour le sujet, qui est corrélé avec l’intérêt du public pour le sujet.

🎓 Les trouvailles de ce papier gagneraient à inspirer l’ISTQB. Son syllabus brille rarement par la variété et la quantité de ses sources académiques, bien qu’il en possède ce qui est rare dans notre secteur. Même commentaire pour le SWEBOK.

SOURCE

Garousi, Vahid and Mika Mäntylä. “A systematic literature review of literature reviews in software testing.” Inf. Softw. Technol. 80 (2016): 195-216.

📄 Lien public

DOIs:

10.1016/J.INFSOF.2016.09.002

Testing, abstraction, theorem proving: better together ! 🔗

🧪 Tests

🔎 L’analyse dynamique (les tests) ne pourra jamais valider tous les comportements possibles d’un programme : elle sous-approxime. A l’inverse, l’analyse statique tend à sur-approximer et à produire un grand nombre de faux-positifs. Est-il possible de prendre le meilleur des deux mondes ? Des chercheurs proposent un moyen d’y parvenir.

🤖 Les tests sont d’abord exécutés afin d’obtenir un jeu d’états concrets du programme. Ce jeu d’états est généralisé en un jeu d’états abstraits, représentant l’ensemble des états dans lequel le programme peut potentiellement se trouver. Un démonstrateur de théorème automatisé va ensuite vérifier que ce jeu d’états abstrait vérifie certaines propriétés désirables et passe lui-même une version généralisée des tests. Si ça n’est pas le cas, le démonstrateur va générer des contre-exemples permettant au développeur d’augmenter la couverture.

🔧 Je n’ai pas trouvé d’outil appliquant ce principe. Les tests de mutation ont mis 25 ans à passer du laboratoire aux IDE, je pense que les prochaines années verront ce type d’outils venir renforcer nos pratiques.

SOURCE

Greta Yorsh, Thomas Ball, and Mooly Sagiv. 2006. Testing, abstraction, theorem proving: better together! In Proceedings of the 2006 international symposium on Software testing and analysis (ISSTA ‘06). Association for Computing Machinery, New York, NY, USA, 145–156. DOI:10.1145/1146238.1146255

📄 Lien public

DOIs:

10.1145/1146238.1146255

Agility From First Principles: Reconstructing the Concept of Agility in Information Systems Development 🔗

🧮 Méthodes de développement

😶🌫️ L’agilité est au départ un pur label : c’est la mise en commun de la visibilité de plusieurs méthodes autour d’un manifeste flou. Le temps n’a pas aidé à trouver une définition stable, tant le mot est revendiqué par des courants différents. Pire : le mot est antérieur à son usage dans le monde du logiciel. Un consensus se dégage autour de 2 notions : flexibilité et maigreur (leanness). Être Agile serait donc posséder ces deux traits.

🤸 La flexibilité est la capacité à changer de manière réactive ou proactive. Est-ce suffisant pour être agile ? Certainement pas. Une organisation lentement flexible ne sera pas perçue comme agile. L’agilité est également une ouverture au changement : une organisation résiliente, capable de changer au besoin, sans que le changement ne soit accueilli favorablement n’est pas agile.

⚙️ La maigreur est une emphase sur l’économie, la qualité et la simplicité dans la contribution à la valeur perçue par le client. L’inclusion de lean dans l’agilité est problématique : une organisation maigre sacrifie de la résilience pour être la plus efficiente possible. Elle n’est donc pas conçue pour changer, bien au contraire. L’agilité tord quelque peut la définition toyotiste d’origine en cherchant la manière la plus efficiente de produire dans des environnements en perpétuel changement. C’est surtout possible grâce à la nature immatérielle du code.

SOURCE

Conboy, Kieran. (2009). Agility From First Principles: Reconstructing the Concept of Agility in Information Systems Development. Information Systems Research. 20. DOI:10.1287/isre.1090.0236

📄 Lien public

DOIs:

10.1287/isre.1090.0236

Value Creation by Agile Projects: Methodology or Mystery? 🔗

🧮 Méthodes de développement

💵 L’agilité est une chose étrange. Tout le monde parle de “Business Value” mais aucun auteur ne la définit sérieusement. Pour les développeurs, c’est sans doute mieux, car ils peuvent estimer leurs tâches sans retomber dans un culte du mois-homme. Pour le management, c’est bien plus problématique, car ils n’ont qu’un indicateur qualitatif, subjectif et mélangeant la valeur apportée par le logiciel avec celle apportée par le reste des fonctions de l’entreprise.

🤞 Pire, cet indicateur doit être mesuré en se mettant dans la peau du client, mais dans les faits, ce sont toujours des acteurs internes à l’entreprise qui ont ce rôle, avec tout les risques de décalage que cela produit. Une équipe de développement rusée est ainsi poussée à faire plaisir au management, non à un client réel. Formulé en termes économiques, la Business Value n’est pas directement une Dollar Value et la traduction de l’un en l’autre est tout sauf évidente.

🔀 La Business Value est floue, mais est-ce un problème ? Le but de l’agilité est de toujours sortir la tâche la plus prioritaire pour le client à un instant T, rien de plus. Elle n’a pas pour but de compter en valeur absolue, mais d’ordonner en valeur relative. Tout management fait des paris sur ce qu’il comprend du besoin de son client, l’adéquation entre Business Value et Dollar Value, calculée a posteriori, est surtout un bon moyen pour le management de savoir s’il a réussi.

SOURCE

Racheva, Z., Daneva, M., Sikkel, K. (2009). Value Creation by Agile Projects: Methodology or Mystery?. In: Bomarius, F., Oivo, M., Jaring, P., Abrahamsson, P. (eds) Product-Focused Software Process Improvement. PROFES 2009. Lecture Notes in Business Information Processing, vol 32. Springer, Berlin, Heidelberg. DOI:10.1007/978-3-642-02152-7_12

📄 Lien public

DOIs:

10.1007/978-3-642-02152-7_12

Surviving software dependencies 🔗

📐 Architecture

🕵️ Aucune entreprise n’embauche de développeur sans de couteux tests, fréquemment hors-sujet d’ailleurs. Vérification du CV, évaluation du niveau technique, voire véritable enquête de détective pour les plus anxieux. Pourtant, une fois dans l’entreprise, le développeur est parfaitement libre de taper ‘npm install’ ou autre commande similaire. Il fait entrer du code arbitraire comme dépendance du SI, sans que personne ne vienne l’embêter. Le geste est devenu naturel pour les développeurs tant il est facile. Jamais les écoles d’informatique n’abordent le sujet de la gestion irresponsable des dépendances dans notre profession.

😱 Se plaindre de l’irruption de l’IA dans le monde du développement est une panique morale tant que les entreprises ne considéreront pas sérieusement la gestion des dépendances externes de leurs logiciels. Ce papier est un condensé, le minimum vital à connaître pour ne pas mettre en danger son entreprise.

SOURCE

Russ Cox. 2019. Surviving software dependencies. Commun. ACM 62, 9 (September 2019), 36–43. DOI:10.1145/3347446A

📄 Lien public

DOIs:

10.1145/3347446

Historical Roots of Agile Methods: Where Did “Agile Thinking” Come From ? 🔗

🧮 Méthodes de développement

🔎 D’où viennent l’agilité et la mentalité agile ? Les chercheurs ont bien du mal à répondre à cette question, tant le légendaire, l’informel et la reconstruction a priori divergent d’avec les sources authentifiées.

🌀 Beaucoup d’idées viennent évidemment des méthodes “pré-agiles” des années 80-90 comme EVO de Tom Glib ou RAD : le concept de livraison continue à partir d’un MVP et l’objectif ultime de livrer un maximum de valeur au client tirent leur origine de ces méthodes. Il n’est pas impossible que les travaux de Lehman et de Boehm soient indirectement derrière.

📜 Dijkstra et son “Humble Programmer” semble un ouvrage fondateur, au même titre que “Death March” de Yourdon et “The Cathedral and the Bazaar” de Raymond. Rien de scientifique, mais ce sont des ouvrages sapientiaux encore recommandés aujourd’hui.

🧟 Le reste n’a soit aucune origine connue, soit manque de preuves et relève de la légende plus que de l’histoire du logiciel, comme l’origine de Crystal selon Cockburn ou celle d’XP selon Beck.

SOURCE

Abbas, N., Gravell, A.M., Wills, G.B. (2008). Historical Roots of Agile Methods: Where Did “Agile Thinking” Come From?. In: Abrahamsson, P., Baskerville, R., Conboy, K., Fitzgerald, B., Morgan, L., Wang, X. (eds) Agile Processes in Software Engineering and Extreme Programming. XP 2008. Lecture Notes in Business Information Processing, vol 9. Springer, Berlin, Heidelberg. DOI:10.1007/978-3-540-68255-4_10

DOIs:

10.1007/978-3-540-68255-4_10

Exploring the duality between product and organizational architectures: A test of the “mirroring” hypothesis 🔗

🪞 « Toute organisation qui conçoit un système, au sens large, concevra une structure qui sera la copie de la structure de communication de l’organisation. ». Tout le monde connaît la Loi de Conway, que les chercheurs appellent “hypothèse miroir”. Trop peu sont au courant qu’il s’agit d’une hypothèse validée par la recherche en sociologie du logiciel.

🪢 Prenez plusieurs logiciels réalisant une fonction similaire, comparez leurs architectures à la structure des organisation qui les ont développés. Une correlation va se retrouver entre le couplage de l’organisation et la modularité du projet. Les chercheurs avancent des hypothèses pour expliquer cela, mais aucune n’est testée.

SOURCE

Alan MacCormack, Carliss Baldwin, John Rusnak, Exploring the duality between product and organizational architectures: A test of the “mirroring” hypothesis, Research Policy, Volume 41, Issue 8, 2012, Pages 1309-1324, ISSN 0048-7333, DOI:10.1016/j.respol.2012.04.011.

📄 Lien public

DOIs:

10.1016/j.respol.2012.04.011

Exploiting style in architectural design environments 🔗

📐 Architecture

🖌️ Les styles sont au coeur de l’architecture logicielle. Ce sont eux qui définissent les typologies concrètes de connecteurs et de composants, ainsi l’interprétation sémantique à donner aux compositions d’éléments contraints par les règles qu’ils édictent.

🌅 Les styles les plus courants de cette époque n’ont rien de suranné pour le praticien de 2025 :

- Pipes&Filters a retrouvé une jeunesse avec les ETL et les outils Low-Code.

- Le style appelé Real-Time ressemble furieusement à nos architectures réactives.

- Le syle Event-Based, aussi appelé Pub-Sub est simplement partout à l’heure des microservices, pas toujours pour le meilleur.

🔧 Ce papier visait à créer un outil générique permettant de représenter les styles architecturaux, s’il n’a pas survécu, la synthèse de ce concept peut encore nous apprendre beaucoup aujourd’hui.

SOURCE

David Garlan, Robert Allen, and John Ockerbloom. 1994. Exploiting style in architectural design environments. In Proceedings of the 2nd ACM SIGSOFT symposium on Foundations of software engineering (SIGSOFT ‘94). Association for Computing Machinery, New York, NY, USA, 175–188. DOI:10.1145/193173.195404

📄 Lien public

DOIs:

10.1145/193173.195404

Software Architecture 🔗

📐 Architecture

🔬 L’architecture fut d’abord un artisanat, transmis d’architecte en architecte. Les nouveaux styles étaient des variations de styles existants. Les chercheurs vinrent identifier des patterns, afin de théoriser et de rationnaliser cette discipline au cours des années 1990. Le but était d’identifier des styles courants, afin de permettre leur réemploi. Les design patterns devaient bien avoir leur équivalent en architecture.

👓 Des langages descriptifs sont nés, chacun supportant une vue précise de l’architecture. Un même système n’est pas représenté de la même manière par les développeurs, les ingénieurs réseaux et aujourd’hui par les DevOps et les gens du Cloud. Tous sont au moins d’accord sur l’existence de deux choses : des composants et des connecteurs qui les relient.

🏢 L’architecture fut d’abord un artisanat et peut-être aurait-elle dû en rester là, co-évoluant avec les chercheurs. Les années 2000 l’ont vue s’industrialiser. Les styles se sont calcifiés en frameworks, les environnements se sont fermés. L’architecture est passée du jeu de Lego au lit de Procuste. L’autorité normative n’est plus le chercheur, mais celui qui vend son framework au plus d’entreprises possible. Un vaste marché de l’édition et de la formation a terminé de fragmenter la discipline en chapelles. Ce papier date seulement de 2001 et il le déplore déjà.

SOURCE

D. Garlan, “Software Architecture”, Carnegie Mellon University, 2001, doi:10.1002/9780470050118.ecse375

📄 Lien public

DOIs:

10.1002/9780470050118.ecse375

A field guide to boxology: preliminary classification of architectural styles for software systems 🔗

📐 Architecture

📋 Peut-on classer les styles architecturaux comme les design patterns l’ont été dans les années 1990 ? Le travail de Shaw et Clements s’est voulu une première pierre à un tel édifice. 2 familles ont été analysées : Pipes&Filters et Cooperative Message-Passing Processes. Chacune compte plusieurs styles, classés sur 11 critères et brièvement décrits.

🌱 Les auteurs donnent un arbre de décision permettant de choisir le bon style selon les exigences du projet, esquissant un lien qu’approfondira Roy Fielding quelques années plus tard.

🫢 Hélas ce travail reste aujourd’hui sans suite, 30 ans plus tard. Le praticien doit se débrouiller avec des billets de blog approximatifs pour sélectionner un style architectural convenant aux exigences de son projet. Le choix d’un style architectural obéit bien plus aux modes du moment qu’à des critères de décision rationnels.

SOURCE

Shaw, Mary and Paul C. Clements. “A field guide to boxology: preliminary classification of architectural styles for software systems.” Proceedings Twenty-First Annual International Computer Software and Applications Conference (COMPSAC’97) (1997): 6-13. DOI:10.1109/CMPSAC.1997.624691

📄 Lien public

DOIs:

10.1109/CMPSAC.1997.624691

Reconciling the Needs of Architectural Description with Object-Modeling Notations 🔗

📐 Architecture

🙅 UML est-il un bon langage pour représenter l’architecture ? Non, pour deux raisons principales. La première est qu’il n’offre aucune manière meilleure que les autres de représenter les composants, les connecteurs et les notions associées en UML. La seconde est que parmi toutes les manières de faire, aucune ne permet de restituer fidèlement ces concepts dans leur intégralité.

😶🌫️ Il n’est pas interdit d’utiliser UML, le monde de l’architecture est une jungle sans standards véritables, mais il vaut mieux être conscient de ses limites et définir d’entrée de jeu une manière non-ambigüe de représenter les éléments de l’architecture.

SOURCE

Garlan, David & Cheng, Shang-Wen & Kompanek, Andrew. (2002). Reconciling the needs of architectural description with object-modeling notations. Sci. Comput. Program.. 44. 23-. DOI:10.1016/S0167-6423(02)00031-X.

📄 Lien public

DOIs:

10.1016/S0167-6423(02)00031-X

The golden age of software architecture 🔗

📐 Architecture

·

👔 Avis d'expert

🔎 L’architecture logicielle est née dans la seconde moitié des années 80. Il s’agissait pour les chercheurs d’identifier les solutions que les praticiens avaient imaginées pour orchestrer des systèmes logiciels comportant de nombreux modules. La théorisation, d’abord balbutiante, s’est faite dans les années 1990. Le fouillis qu’est encore aujourd’hui l’architecture, où cohabite bullshit et pépites, vient de cette théorisation parcellaire et a posteriori.

🌟 Les années 2000 sont qualifiées d’âge d’or de l’architecture par les auteurs de cet article de synthèse. Les premiers standards sont établis, les premières formations sont dispensées et les éditeurs vomissent des dizaines de livres plus ou moins inspirés. Il aura fallu 20 ans. Quiconque connaît la manière dont les technologies maturent ne sera pas surpris.

🚀 Notre papier du jour a été publié en 2006. Ses auteurs n’ont pas connu le désamour des développeurs pour l’architecture dans les années 2010, ni sa réappropriation actuelle, sous l’impulsion du mouvement craft. Quelle sera la suite de l’histoire ? A nous de l’écrire, en espérant qu’elle se fasse sans UML, déjà qualifié d’erreur dans ce papier.

SOURCE

M. Shaw and P. Clements, “The golden age of software architecture,” in IEEE Software, vol. 23, no. 2, pp. 31-39, March-April 2006, DOI:10.1109/MS.2006.58

📄 Lien public

DOIs:

10.1109/MS.2006.58

Classes versus prototypes in object-oriented languages 🔗

🔣 Science des Langages

🤯 L’idée de baser l’orienté objet sur des prototypes plutôt que sur des classes date de 1986. C’est une réaction à l’introduction des métaclasses en Smalltalk, concept jugé très peu intuitif (les pythonistes modernes témoigneront). Borning affirme que les classes des langages orientés-objet portent bien trop de responsabilités : générateurs d’instances, descripteurs de protocoles, descripteurs de représentation, etc.

📑 La solution proposée est d’abolir les classes. Tout nouvel objet est la copie d’un ancien, qui peut ensuite être modifié à loisir. Cette copie peut être indépendante de la source, ou lui être liée par des contraintes. Ces contraintes peuvent lier ensemble les champs, le comportement ou le protocole des deux objets. Une copie contrainte sur les trois se nomme un descendant.

🚫 Aucune étude, même sur des étudiants, n’a été effectuée avant d’affirmer que ce modèle est plus clair que la POO “vanilla” ou les métaclasses. Pourtant l’auteur affirme qu’ayant moins de concepts à apprendre, le débutant sera moins perdu. Celui-ci est pourtant clairvoyant sur les défauts de sa proposition : elle n’est pas naturelle pour les pures abstractions comme les nombres. Quel est l’entier prototypal ? 0 ou 1 ? Un prototype de Stack ou de Queue fait-il sens ? Enfin, à l’époque, le copy-on-write n’existait pas et les performances d’un langage à prototype n’auraient pas été flamboyantes.

🏛️ La philosophie aristotélico-thomiste est gravée dans nos têtes d’occidentaux, pour le meilleur et pour le pire. Sortir de cette dualité objet/concept est une impasse en programmation, car cette dualité nous est enseignée depuis notre enfance. Qu’elle soit naturelle ou culturelle importe peu à ce stade.

SOURCE

A. H. Borning. 1986. Classes versus prototypes in object-oriented languages. In Proceedings of 1986 ACM Fall joint computer conference (ACM ‘86). IEEE Computer Society Press, Washington, DC, USA, 36–40. DOI:10.5555/324493.324538

📄 Lien public

DOIs:

10.5555/324493.324538

Contracts: specifying behavioral compositions in object-oriented systems 🔗

🔣 Science des Langages

📃 Les contrats ont été inventés en 1990 afin de compléter les interfaces des classes. Ces dernières donnent les signatures des méthodes exposées par une classe, mais ne disent rien du comportement que chacune des parties attend de l’autre. Les commentaires sont largment insuffisants, car il faut que de telles spécifications soient exécutables.

🌱 La première idée émise par les chercheurs fut d’intégrer les contrats dans les langages de programmation eux-mêmes. Cette idée n’a pas pris, mais les contrats sont loin d’être morts ! Les tests fonctionnels sont les héritiers directs de ce morceau d’histoire du logiciel. Plus éloignés, certains types de foncteurs (Maybe, Lazy, Either, …) ou les systèmes de Tasks/Promises peuvent se rattacher à des contrats.

SOURCE

Richard Helm, Ian M. Holland, and Dipayan Gangopadhyay. 1990. Contracts: specifying behavioral compositions in object-oriented systems. SIGPLAN Not. 25, 10 (Oct. 1990), 169–180. DOI:10.1145/97946.97967

📄 Lien public

DOIs:

10.1145/97945.97967

Green code : towards measuring the efficiency of software system execution 🔗

🪫 Comment produit-on un logiciel économe en énergie ? Sans surprise, il faut déjà que le besoin en soit exprimé. C’est une exigence non-fonctionnelle et aucun développeur ne s’en préoccupe si ça n’est pas formulé sous forme d’objectifs chiffrés.

📏 Ensuite, il faut que le développeur puisse mesurer la consommation de son programme. Il faut de l’outillage pour cela, notamment en intégration continue. Hélas le papier reste en surface et ne nous dit pas lesquels.

⚡ Mesurer ne sert à rien si l’on ne peut pas agir. Les développeurs doivent se former à repérer les antipatterns énergétiques au niveau architectural, dans le design ou les structures de données. Certains patterns sont connus pour favoriser les économies d’énergie. Problème : certaines bonnes pratiques logicielles semblent alourdir le bilan energétique des projets, comme l’encapsulation, en tout cas sur certains langages. A l’inverse, le bon usage du multithreading permet souvent des économies importantes. Plus surprenant, la pratique du refactoring semble liée à une meilleure efficacité energétique.

👟 Tous les frameworks, bibliothèques et bases de données ne se valent pas, certains sont des gouffres énergétiques, l’auteur note hélas que ce sont souvent les dépendances les plus performantes qui sont aussi les moins efficientes. Cette tension se retrouve également dans les réglages des compilateurs C/C++ où les optimisations les plus aggressives ne sont pas toujours les plus vertes. Sans surprise, la conteneurisation, voire pire la virtualisation sont des gouffres énergétiques.

SOURCE

Rifat, Ahmed, Green code : towards measuring the efficiency of software system execution. School of Engineering Science, Tietotekniikka. 2022.

📄 Lien public

Secure Software Development Methodologies: A Multivocal Literature Review 🔗

🧮 Méthodes de développement

🔒 Les méthodologies de Secured Software Development sont nombreuses, populaires et font même l’objet de normes gouvernementales depuis une demi-décennie. Trois raisons de s’en méfier, donc.

📐 Chercheurs, gouvernements et praticiens s’accordent sur un socle commun de pratiques : évaluation des risques, création d’une culture de la sécurité et standards de code. En dehors de ce noyau commun, les pratiques recommandées divergent.

🤡 Les auteurs de cette revue de littérature relèvent l’absence quasi-totale de justification des pratiques recommandées par ces méthodologies. La charge de la preuve leur incombe, pourtant. Ils notent également l’absence d’évaluation de l’efficacité de telles méthodologies, pointant ironiquement que les entreprises desquelles elles sont issues ont été remarquées pour des hacks massifs depuis la parution de leurs méthodes.

⛓️ Ajoutons que très peu de méthodes envisagent le développeur comme un acteur de la sécurité. Au mieux leur impose-t-on des standards de code et des revues de leur travail par des experts. La plupart des frameworks se contentent de faire de la gestion de risque, à mille lieux de méthodologies de développement, sécurisé ou non.

SOURCE

Kudriavtseva, Arina and Olga Gadyatskaya. “Secure Software Development Methodologies: A Multivocal Literature Review.” ArXiv DOI:abs/2211.16987 (2022)

📄 Lien public

DOIs:

10.48550/arXiv.2211.16987

Hints on Test Data Selection: Help for the Practicing Programmer 🔗

🧪 Tests

🧪 En 1978, quasiment tout ce qu’un développeur de 2025 doit savoir sur les tests avait déjà été dit. Comment sélectionner les cas de test pour éviter le Happy Path Testing ? Goodenough et Gerhart en 1975. L’idée des tests de mutation ? Budd, DeMillo et Lipton en 1978. L’hypothèse du programmeur compétent ? Youngs en 1971. Le rapport logarithmique entre effort de test et découverte de bugs ? Tucker en 1965.

🥊 Ce papier de 1978 vulgarise avec brio tous les concepts susmentionnés. En 2025, personne n’a d’excuses pour les ignorer, sinon un parcours de formation défaillant.

SOURCE

DeMillo, Richard A., Richard J. Lipton and Frederick G. Sayward. “Hints on Test Data Selection: Help for the Practicing Programmer.” Computer 11 (1978): 34-41. DOI:10.1109/C-M.1978.218136

📄 Lien public

DOIs:

10.1109/C-M.1978.218136

Agile Gets Physical : Slice-Based Integration 🔗

👔 Avis d'expert

·

🧪 Tests

🤖 L’agilité fait grincer les dents dans le monde du hardware. Réaliser une carte électronique est tellement long que personne ne s’amuse à ajouter chaque feature itérativement. Ca n’est même pas physiquement possible dans la plupart des cas.

🚧 Le hardware connaît cependant le développement incrémental, c’est là que nous pouvons nous entendre. Avant le produit fini, l’ingénieur conçoit tout un bestiaire de prototypes de plus en plus aboutis, avec lesquels les développeurs peuvent composer pour exécuter les tests du software.

⌚ Peu d’effort est demandé au hardware : seulement de s’aligner sur des jalons convenus avec les développeurs. Chaque jalon spécifie un ensemble de cas d’utilisation que toutes les équipes devront tester ensemble de manière intégrée à une échéance donnée. Chacun retourne travailler après s’être accordé sur une interface commune, permettant le développement de doubles de test propres à chacun. Le jour J, on met en commun et on teste. Les réalignements se font à l’incrément suivant jusqu’au produit fini.

⚠️ Cette méthode semble prometteuse, mais ce papier ne fait que la présenter, sans conduire d’étude prouvant son efficacité.

SOURCE

Iberle, Kathleen (2022). Agile Gets Physical : Slice-Based Integration. PNSQC Proceedings.

📄 Lien public

Encapsulation and inheritance in object-oriented programming languages 🔗

📦 L’orienté-objet moderne ne s’est pas figé du jour au lendemain. Les différences entre les langages actuels portent les cicatrices des débats qui ont eu lieu dans les années 1980, à l’époque où ce paradigme se consolidait. Ces papiers n’ont plus aucun intérêt scientifique, sauf pour les amoureux de l’histoire du logiciel qui y trouveront les minutes des débats qui ont animé la communauté objet.

❓ Alan Snyder explore ici les liens pas si évidents entre héritage et encapsulation. L’enfant doit-il accéder aux parties privées du parent ? Être traité en étranger ? Quelque chose entre les deux (ce qui deviendra le mot clé protected) ? Le fait qu’une classe hérite d’une autre doit-il être une information accessible au reste du programme ? Ces questions ont été tranchées, mais il est toujours intéressant de comprendre le chemin intellectuel qui nous a mené à la situation actuelle.

SOURCE

Snyder, Alan. “Encapsulation and inheritance in object-oriented programming languages.” OOPLSA ‘86 (1986). DOI:10.1145/960112.28702

📄 Lien public

DOIs:

10.1145/960112.28702

Designing Reusable Classes 🔗

👔 Avis d'expert

·

#️⃣ Façonnage de code

🧊 Certains papiers sont des instantanés des erreurs de leur époque et méritent leur place ici principalement pour cela. Le début de celui-ci est une description claire et impeccable de ce qu’est l’orienté-objet à la fin des années 80. Presque rien n’a changé depuis, seulement quelques additions mineures.

🔗 La suite porte sur les frameworks : ils y sont correctement décrits comme étant plus que de simples boîtes à outils. Tout framework lie irrévocablement le code qui l’utilise à une architecture. L’auteur rappelle une distinction aujourd’hui oubliée entre frameworks white-box et black-box, les premiers ayant presque disparu du marché.

✅ La fin du papier liste des “bonnes pratiques” de l’époque, certaines aujourd’hui réfutées. L’usage de hiérarchies d’héritage profondes est recommandée, alors que nous savons désormais que le nombre de niveaux d’héritage est corrélé au nombre de bugs. La création d’un maximum de code générique et même de frameworks y est encouragée, bien que décrite comme dangereuse, afin de réutiliser au maximum le code. Aujourd’hui il est recommandé d’attendre qu’un besoin de réutilisation existe pour entamer une telle démarche.

🧑🔬 Il est dommage que l’auteur n’ait pas cherché de preuves de l’efficacité de ces différentes règles, mais se soit simplement fait l’écho de l’esprit du temps.

SOURCE

Johnson, Ralph & Foote, Brian. (1988). Designing Reusable Classes. Journal of Object-Oriented Programming.

📄 Lien public

Values and objects in programming languages 🔗

🔣 Science des Langages

🗃️ Les familiers de DDD connaissent la distinction Entité/Objet-Valeur. Peu savent qu’Evans n’a rien inventé : en 1982, Bruce McLennan plaidait pour que les langages orientés-objet n’utilisent pas le même mécanisme pour représenter les valeurs et les objets. Les premières sont des abstractions intemporelles et immuables que la programmation partage avec les mathématiques. Les seconds sont des instances partageant une forme commune (leur classe), mais différent en substance (leur identité et leurs accidents).

🧮 En réalité, McLennan non plus n’a rien inventé, il poursuit simplement la longue tradition d’Aristote, de Saint Thomas d’Aquin et des scolastiques. L’orienté-objet n’a rien de neutre, ce paradigme est l’héritier d’une longue tradition philosophique réaliste. Pour McLennan, les mathémathiques sont trop abstraites et incommodes pour représenter les cas particuliers. A l’inverse, un style de programmation qui ignore la distinction valeur/objet se prive d’outils puissants pour représenter l’abstrait, l’immuable, le calculable et donc la simplicité.

🏛️ Ce papier est à ranger parmi les grands classiques de la programmation. “Programmer, c’est faire des mathémathiques orientées-objet. Mathématiser, c’est faire de la programmation orientée-valeur” résume d’auteur.

SOURCE

MacLennan, Bruce J.. “Values and objects in programming languages.” ACM SIGPLAN Notices 17 (1982): 70-79. DOI:10.1145/988164.988172

📄 Lien public

DOIs:

10.1145/988164.988172

Evaluation of Approaches for Documentation in Continuous Software Development 🔗

🧮 Méthodes de développement

·

🧪 Tests

📖 Même un code exemplaire a besoin d’être accompagné d’une documentation. Concevoir c’est faire des choix, qui doivent être consignés quelque part pour être compris dans le futur. A l’heure actuelle, deux approches ont le vent en poupe : “Just enough Upfront” et “Executable Documentation”. Elles sont trop récentes pour en évaluer les résultats, mais il est cependant possible de baliser le terrain et de savoir de quoi il en retourne.

🖼️ Just enough up Front utilise des supports de documentation déstructurés en amont du développement : présentations, description d’interfaces, schémas. Le développement démarre dès que suffisamment d’informations sont récoltées, et utilise l’abstraction pour garder le code extrêmement perméable au changement. La documentation in fine est le code lui-même, ainsi que les messages de commits.

🧪 Executable Documentation utilise massivement les méthodes de recueil du besoin piloté par les tests, les spécifications et exigences exécutables tout au long du cycle de vie du logiciel. Le reverse engineering est une méthode d’extraction de la connaissance adaptée avec une telle couverture du code.

🧭 Tandis que Just enough up Front est déjà bien installé en entreprise, Executable Documentation souffre de l’obsession mondiale pour les tests unitaires, incapables de supporter cette méthode. C’est dommage car les deux méthodes se complètent bien. L’une permet de savoir où l’on va, l’autre de ne pas oublier ce que l’on voulait accomplir.

📍 Git est le lieu parfait pour documenter du code dans le cadre de ces deux démarches, notent les chercheurs. Les messages de commits sont sous-cotés.

SOURCE

Theunissen, Theo & Hoppenbrouwers, Stijn & Overbeek, Sietse. (2023). Evaluation of Approaches for Documentation in Continuous Software Development. 404-411. DOI:10.5220/0011846200003464.

📄 Lien public

DOIs:

10.5220/0011846200003464

Understanding and Detecting Harmful Code 🔗

🦨 Code Smells

🐛 La plupart des odeurs du code ne sont pas corrélées à la présence de bugs et inversement, la plupart des bugs ne sont pas liés à des odeurs du code. Ces deux concepts désignent des réalités différentes. Une seule odeur du code ressort du lot en étant modérément corrélée à l’apparition de bugs : l’appel de méthodes abstraites depuis le constructeur. S’il faut prioriser un refactoring c’est bien celui-ci.

🔎 Le papier vise surtout à améliorer les outils de détection de bugs. En remontant depuis les odeurs jusqu’aux métriques permettant de les détecter automatiquement, les chercheurs en ont sélectionné plusieurs qui sont modérément corrélées à l’apparition de bugs. Rien de surprenant pour un développeur chevronné : nombre excessif de paramètres, nombre excessif de méthodes par classes, complexité ou longueur extrême d’une méthode. Rien de nouveau sous le soleil.

SOURCE

Rodrigo Lima, Jairo Souza, Baldoino Fonseca, Leopoldo Teixeira, Rohit Gheyi, Márcio Ribeiro, Alessandro Garcia, and Rafael de Mello. 2020. Understanding and Detecting Harmful Code. In Proceedings of the XXXIV Brazilian Symposium on Software Engineering (SBES ‘20). Association for Computing Machinery, New York, NY, USA, 223–232. DOI:10.1145/3422392.3422420

📄 Lien public

DOIs:

10.1145/3422392.3422420

Identification and measurement of Requirements Technical Debt in software development: A systematic literature review 🔗

🧮 Méthodes de développement

💰 Depuis Ward Cunningham, le concept de dette technique a été étendu, souvent abusivement. L’une de ses ramifications contemporaines, la dette technique d’exigence (requirements technical debt) désigne tout écart entre les spécifications idéales et les spécifications réelles du projet. On y retrouve l’exclusion de certaines parties prenantes, les mauvaises techniques d’élicitation, l’implémentation non-conforme. Dette ou malfaçon, je vous laisse juges, mais vu que le terme est utilisé en recherche, il faut bien l’accepter pour débattre du sujet.

🤝 Les pricipaux remèdes sont la revue des spécifications par le client (encore faut-il un format qu’il puisse lire) et le recueil du besoin en face à face, non par documents interposés. De vieilles recettes.

🧮 La quantification et la priorisation de la dette technique sont des sujets prometteurs mais complexes. La dette intentionnelle, celle de la définition d’origine, est facile à quantifier et à prioriser. La quantification de dette non-intentionnelle relève de la divination. Le concept recouvre surtout des failles organisationnelles qui n’ont rien à voir avec la métaphore d’une “dette”. La dette technique d’exigences n’en fait pas partie et les auteurs recommandent plus volontiers de prévenir que de quantifier, prioriser et remédier à un recueil du besoin défaillant.

* Le lien redirige vers le dernier preprint, car le papier définitif est derrière un paywall.

SOURCE

Melo, Ana & Fagundes, Roberta & Lenarduzzi, Valentina & Santos, Wylliams. (2022). Identification and measurement of Requirements Technical Debt in software development: A systematic literature review. Journal of Systems and Software. 194. 111483. 10.1016/j.jss.2022.111483.

📄 Lien public

DOIs:

10.1016/j.jss.2022.111483

How Does Modern Code Review Impact Software Design Degradation? An In-depth Empirical Study 🔗

🧮 Méthodes de développement

💣 Les Code Reviews n’empêchent pas l’érosion du design d’un logiciel, voire l’aggravent dans certains cas. Si une review n’est pas explicitement dédiée à l’amélioration du design, mieux vaut d’abstenir d’y toucher. Même lorsqu’une review s’intéresse explicitement au design, elle tend à ne régler que les problèmes localisés et n’a pas d’impact sur les problèmes plus larges, nécessitant le remaniement de nombreux éléments.

🥊 Plus une review est conflictuelle et s’enlise dans les débats, plus le design a de chances d’être dégradé. L’amélioration d’un aspect du design tend de surcroît à se faire au détriment d’autres éléments. Seul l’implication véritablement active de plusieurs reviewers permet de sauver les meubles. A ce prix là, ne serait-il pas plus pertinent de faire directement réaliser le code par plusieurs devéloppeurs ?

SOURCE

Uchôa, Anderson & Barbosa Vieira da Silva, Caio & Oizumi, Willian & Blenilio, Publio & Lima, Rafael & Garcia, Alessandro & Bezerra, C. I. M.. (2020). How Does Modern Code Review Impact Software Design Degradation? An In-depth Empirical Study. DOI:10.1109/ICSME46990.2020.00055.

📄 Lien public

DOIs:

10.1109/ICSME46990.2020.00055

Evolution of Software Testing Strategies and Trends: Semantic Content Analysis of Software Research Corpus of the Last 40 Years 🔗

🧪 Tests

⌚ 40 ans de recherche sur les tests résumés en un papier académique ? Une équipe turco-norvégienne l’a réalisé. Il s’agit ici de recenser les grandes tendances de chaque demi-décennie, de manière quantitative.

🧪 L’intérêt des chercheurs pour les tests naît dans les années 80 où la recherche se concentre sur l’outillage adéquat et la détection des bugs. La décennie 90 a exploré le sujet de la génération des cas de tests. Les années 2000 ont évalué les résultats des différentes approches de manière empirique avant que la décennie qui nous précède ne s’intéresse à la prédiction des défauts. Les chercheurs parient que l’avenir vera des percées dans la sécurité, l’open-source et le mobile.

🗨️ Ce papier est utile pour qui veut connaître les grands courants de la recherche, sans discriminer les papiers qui ont fait école de ceux qui sont tombés dans l’oubli. L’exercice est intéressant mais mériterait une suite où chaque papier est pondéré selon le nombre et la longévité des citations.

SOURCE

Gurcan, Fatih & Menekşe Dalveren, Gonca & Cagiltay, Nergiz & Roman, Dumitru & Soylu, Ahmet. (2022). Evolution of Software Testing Strategies and Trends: Semantic Content Analysis of Software Research Corpus of the Last 40 Years. IEEE Access. PP. 1-1. DOI:10.1109/ACCESS.2022.3211949.

📄 Lien public

DOIs:

10.1109/ACCESS.2022.3211949

Test-Driven Development with the Focus on Inexperienced Programmers: A Literature Review 🔗

🧪 Tests

🧪 Chez les débutants, TDD et TLD permettent d’atteindre une qualité produit similaire. Ces résultats sont confirmés par une revue de littérature de 2022. Celle-ci nous apprend aussi que TDD permet une meilleure couverture de tests que TLD, donc potentiellement une meilleure capacité anti-régression, mais est plus difficile à apprendre. Les pièges sont nombreux pour les débutants en TDD : les étudiants tendent à ne pas comprendre immédiatement la démarche et à ne pas refacto une fois les tests au vert. Ils sont souvent adeptes du happy-path testing, donc de tests peu approfondis. Avec de l’entraînement et un suivi correct, ces problèmes sont rapidement corrigés.

SOURCE

Nyman A, Rimmi O. Test-Driven Development with the Focus on Inexperienced Programmers: A Literature Review. 2022.

📄 Lien public

Iteration Causes, Impact, and Timing in Software Development Lifecycle: SLR 🔗

🧮 Méthodes de développement

🔁 Itérer est toujours une perte de temps et d’argent. Un développeur omniscient recueillant un besoin parfait travaille de manière linéaire. Aucune itération volontaire ne lui est nécessaire, car le problème est bien défini. Il ne cause pas d’itérations involontaires car il produit un code simple, exempt de défauts, adéquat par rapport au besoin, sans aucune ambiguïté.

🧚 Si nous quittons le monde des fées, l’itération est bourrée d’avantages : qualité en hausse donc baisse des défauts, meilleure lisibilité donc meilleure maintenabilité, plus faible complexité donc plus grande productivité, adoption d’une solution plus adaptée au problème et plus innovante. Autrement dit, itérer c’est compenser nos limites bien humaines par une méthode d’amélioration continue. Nous sommes en négociation permanente avec les autres parties prenantes, nous-même et surtout la froide logique des machines.

🪙 La seule raison pertinente de ne pas itérer, c’est de gagner du temps à court-terme, au détriment du temps long. C’est ce que l’on appelle la dette technique.

📚 Voici les conclusions d’une équipe pakistano-saoudienne, qui a réalisé une SLR sur près de 153 études après sélection qualitative.

SOURCE

Mumtaz, Mamoona & Ahmad, Naveed & Ashraf, M. Usman & Alghamdi, Ahmed & Bahadad, Adel & Almarhabi, Khalid. (2022). Iteration Causes, Impact, and Timing in Software Development Lifecycle: SLR. IEEE Access. 10. 1-1. DOI:10.1109/ACCESS.2022.3182703.

📄 Lien public

DOIs:

10.1109/ACCESS.2022.3182703

Debugging reinvented 🔗

🧮 Méthodes de développement

🔍 Une fois localisée l’origine de l’erreur, celui qui débugge doit savoir pourquoi la valeur est erronnée. Les débuggers actuels sont laborieux car ils expliquent quelle est la valeur d’une variable, non qui la lui a donnée. Une équipe de Carnegie-Mellon a conçu un outil fonctionnel permettant de suivre les éditions successives d’une variable afin de répondre à la question la plus chronophage du debug : pourquoi ?

💣 Ils sont mêmes allés plus loin : parfois une valeur devrait changer, mais ne change pas. A l’aide d’heuristiques simples, ils ont pu répondre également à la question “pourquoi pas ?”.

❓ A ce jour, je ne connais aucun outil de debug utilisant ce principe. Quelqu’un en connaît-il un ?

SOURCE

Ko, Amy J. and Brad A. Myers. “Debugging reinvented.” 2008 ACM/IEEE 30th International Conference on Software Engineering (2008): 301-310. DOI:10.1145/1368088.1368130

📄 Lien public

DOIs:

10.1145/1368088.1368130

Finding Failure Causes through Automated Testing 🔗

🧪 Tests

🐛 Une révision fonctionne, alors qu’une autre bugge. C’est presque une routine. Le développeur doit alors rechercher la cause racine du bug et la corriger. L’usage de tests dans ce processus est ancien, bien qu’il ne soit apparu dans la littérature scientifique qu’autour des années 2000. L’idée est simple : reproduire le bug dans un cas de test pour l’empêcher de revenir. C’est le defect testing. Hélas, cette technique n’aide pas à trouver la cause racine, ce qui représente 95% du temps de debug.

🧪 Deux chercheurs allemands proposent d’utiliser les tests afin de repérer la cause racine. Il faut pour cela deux révisions séparées par un delta. Dans la première, le test de défaut fonctionne, dans l’autre celui-ci est cassé. L’étape suivante est de trouver le scénario minimal dans lequel le bug se produit, en diminuant la quantité de changements du delta. Cette étape n’est pas obligatoire, mais réduit largement la quantité de calculs nécessaires ensuite. La dernière étape consiste à muter le code afin de trouver le plus petit jeu de changements provoquant le bug, donc faisant passer au rouge le test de défaut. Cette étape est extrêmement lourde en calculs, car le nombre de mutants à générer et tester est immense.

🗜️ Cette technique n’est pas utilisée en l’état par les praticiens, à ma connaissance. Elle pourrait cependant être à l’origine du shrinking utilisé en property-based testing.

SOURCE

Cleve, Holger and Andreas Zeller. “Finding Failure Causes through Automated Testing.” arXiv: Software Engineering (2000) DOI:10.48550/arXiv.cs/0012009

📄 Lien public

DOIs:

10.48550/arXiv.cs/0012009

The Impact of using a Contract-Driven, Test-Interceptor based Software Development Approach 🔗

#️⃣ Façonnage de code

·

🧪 Tests

📃 La programmation par contrats est impopulaire, malgré ses preuves d’efficacité. Pour la rendre sexy, des chercheurs ont envisagé d’utiliser les contrats comme moyen de générer des tests avant le code, comme alternative à Behavior-Driven-Design. Ils ont évidemment appelé leur découverte Contract Driven Design selon la coutume.

🚧 Des intercepteurs sont utilisés afin de vérifier que les pré-conditions, les post-conditions et les invariants sont respectés sur le composant, dont seule l’interface est visible. Le dépôt git n’étant plus accessible, je n’ai pas pu voir en détail comment ces intercepteurs sont appelés par le moteur de tests, mais l’idée ressemble grosso modo au Property-Based Testing, apparu en 1997 dans la littérature et vers 2015 chez les praticiens.

🤔 PBT a l’avantage de ne pas encombrer le code avec les annotations contactuelles, qui doivent être maintenues et bloquent le refactoring. Ces annotations appartiennent plus naturellement au monde des tests qu’au code. Le second inconvénient, pour qui veut concurrencer BDD, est l’opacité des contrats pour le client, alors que l’intérêt de BDD est justement de pouvoir dialoguer avec lui sur un terrain commun. Enfin, l’expérience contenue dans le papier est très faible, pour ne pas dire qu’elle ne prouve rien.

SOURCE

Posthuma, Justus & Solms, Fritz & Watson, Bruce. (2022). The Impact of using a Contract-Driven, Test-Interceptor based Software Development Approach. 39-58. DOI:10.5121/csit.2022.120704.

📄 Lien public

DOIs:

10.5121/csit.2022.120704

Sources of software development task friction 🔗

🧮 Méthodes de développement

·

#️⃣ Façonnage de code

⌨️ Avez-vous déjà codé sur un PC qui n’est pas le vôtre ? L’inconfort naît de la friction, soit la part du temps de développement passé à gérer l’environnement au lieu de coder, plus grande sur un système qui n’est pas ajusté à nos habitudes. La friction a fortement diminué depuis l’époque des cartes perforées mais reste encore importante. Ce papier de 2022 fait le point.

🤖 Le problème fondamental est la médiation de multiples outils entre notre cerveau et notre code. Si nous pouvions simplement penser pour coder, nous éliminerions la friction de traduction. Si l’ensemble de l’information pertinente était directement dans notre tête, nous n’aurions aucune friction d’intégration. Sans la nécessité de coordonner un navigateur, des post-it, un IDE et un terminal, pas de friction d’accès. Sans friction, moins d’erreurs également, comme les commandes shell invalides ou les “solutions” stackoverflow fausses.

🐧 Les IDE promettent de tout faire à un seul endroit, mais c’est un pieux mensonge : il y a autant de manières de réaliser une tâche que de développeurs. Bienheureux celui qui trouve out-of-the-box le bon outil ! Beaucoup se tournent vers un assemblage hétéroclite d’outils simples, dans l’esprit GNU, ce qui augmente la friction d’accès mais améliore les autres formes de friction.

🪄 La solution miracle n’existe pas, Fred Brooks l’a démontré en 1986 dans “No Silver Bullet”, mais par petits incréments successifs, nous adaptons l’outil à notre cerveau. L’IA peut aider mais elle ne sera pas la panacée.

SOURCE

Bradley, N.C., Fritz, T. & Holmes, R. Sources of software development task friction. Empir Software Eng 27, 175 (2022). DOI:10.1007/s10664-022-10187-6

📄 Lien public

DOIs:

10.1007/s10664-022-10187-6

Detecting Argument Selection Defects 🔗

#️⃣ Façonnage de code

🔀 L’inversion de paramètres d’appel d’une fonction est un défaut courant, qui peut rester indétecté longtemps si la couverture de tests n’est pas bonne. Une équipe germano-américaine comptant des chercheurs de Google a voulu déterminer la meilleure approche pour détecter ce problème à l’aide d’un analyseur statique.

💡 L’outillage qu’ils ont développé obtient un score de détection honorable, mais là n’est pas le principal fruit du papier. Ils sont surtout démontré, si c’était encore nécessaire que l’usage de Builder doit toujours être préféré à des paramètres pléthoriques, qu’il faut respecter les conventions (expected avant actual dans les tests) et que l’héritage doit respecter l’ordre des paramètres.

🫙 J’ajoute que si les développeurs cessaient d’utiliser des primitives au profit de types encapsulés, ils n’auraient même pas à se poser la question. Avec 64% de la profession utilisant JS, c’est une utopie.

SOURCE

Andrew Rice, Edward Aftandilian, Ciera Jaspan, Emily Johnston, Michael Pradel, and Yulissa Arroyo-Paredes. 2017. Detecting argument selection defects. Proc. ACM Program. Lang. 1, OOPSLA, Article 104 (October 2017), 22 pages. DOI:10.1145/3133928

📄 Lien public

DOIs:

10.1145/3133928

Evolution of Software Development in the Video Game Industry 🔗

🧮 Méthodes de développement

⚔️ Dans le monde du jeu vidéo, la guerre économique fait rage entre les studios. Il est compliqué pour les chercheurs d’analyser les méthodes de développement de ce secteur. Une équipe d’Oakland y est parvenue à partir des post-mortem que les équipes réalisent presque systèmatiquement après la sortie d’un jeu. Première différence avec l’informatique de gestion.

🎉 L’idée d’impliquer tôt les stakeholders dans les itérations est une question de vie ou de mort dans un jeu : seul un joueur peut savoir si le fun est présent, aucun P.O ou proxy quelconque ne peut le remplacer. C’est une grosse différence avec l’informatique de gestion où le client a rarement du temps à consacrer à cela.

🥷 La problématique du hacking est semblable des deux côtés : certains pratiquent l’exploit pour le fun, d’autres pour en tirer un bénéfice. Les jeux vidéo récents n’ont plus aucune tolérance envers les glitch-exploiters et les tricheurs à cause de la compétition régnant entre les joueurs. Ce n’est plus seulement un loisir.

🐚 Le jeu vidéo utilise bien plus le modèle Spiral que l’Agilité proprement dite. Cette dernière perce dans les entreprises ayant adopté le modèle du Game as a Service, qui divergent de plus en plus de celles restées sur le modèle Game as a Product. L’agilité vient adresser des problèmatiques rencontrées par l’informatique de gestion 15 ans plus tôt, mais sous une forme adaptée aux contraintes du jeu vidéo.

SOURCE

Newell, Kieran & Patel, Kunjal & Linden, Magnus & Demetriou, Michael & Huk, Michal & Mahmoud, Mohammed. (2021). Evolution of Software Development in the Video Game Industry. DOI:10.1109/CSCI54926.2021.00367

📄 Lien public

DOIs:

10.1109/CSCI54926.2021.00367

The 4+1 View Model of architecture 🔗

👔 Avis d'expert

💣 L’acte de naissance de l’Architecture 4+1 de Philippe Kruchten est un sujet difficile à traiter. Avec presque 30 ans de recul peu de choses vont dans ce papier, sans que cela puisse être complètement reproché à l’auteur en 1995. Celui-ci a d’ailleurs changé de position et corrigé sa vision du sujet.

1️⃣ Le premier problème est une confusion permanente entre design et architecture. En 4+1, l’architecte s’encombre de diagrammes de classes, de process et des diagrammes UML correspondants. Nous sommes dans un cas flagrant de Big Design Up Front, une erreur des années 70 ayant mis 30 ans à disparaître. Oui, l’architecture peut être conçue à l’avance, mais certainement pas le design.

2️⃣ Le deuxième problème du papier est son fétichisme de la documentation : l’architecture est déjà une documentation, qu’il faut en plus documenter pour en capter la rationnelle, les scénarios, les charges, etc. Le groupe chargé de cela ne peut qu’y être dédié, créant donc une classe d’architectes séparée du terrain, manipulant de la documentation et des abstractions.

3️⃣ Le troisième problème est épistémologique. Dire en conclusion que ça fonctionne, sans aucune étude ni source fait de ce papier un pur avis d’expert. Hélas, l’influence de M. Kruchten lui a permis de faire école : 1350 citations du papier et 46 brevets s’appuyant dessus. De la part d’un docteur, c’est un problème, mais également un symptôme du fonctionnement de l’IEEE qui a toujours publié ensemble des études chiffrées et des avis d’expert sans étiquetage.

SOURCE

P. B. Kruchten, “The 4+1 View Model of architecture,” in IEEE Software, vol. 12, no. 6, pp. 42-50, Nov. 1995, DOI:10.1109/52.469759

📄 Lien public

DOIs:

10.1109/52.469759

Secure by Design 🔗

👔 Avis d'expert

A l’heure de l’IoT et de l’informatique partout, un programme doit être Secure by Design. Cela suppose d’ajouter des pratiques de sécurité sur toute la chaîne de production du logiciel : Exigences, Design, Implémentation, Tests.

Ce papier extrêmement court est un bon résumé mais n’est pas exhaustif. Rien n’est dit sur le typage fort, l’intérêt de TDD ou encore le pair programming, qui ont pourtant de bons résultats. Les tests ne sont envisagés qu’après le développement ce qui montre un manque de connaissances de l’auteur sur la partie purement Dev. Cybersécurité et qualité logicielle sont deux mondes qui doivent se parler.

SOURCE

Abdulhamid A. Ardo, Julian M. Bass, Head, Tarek Gaber, Secure by Design, gmcyberfoundry.ac.uk

📄 Lien public

Exploring the Influence of Identifier Names on Code Quality: An empirical study 🔗

👌 Qualité logicielle

·

🗣️ Nommage

🌥️ Un nommage obscur est fortement corrélé à un code de piètre qualité, au point même de pouvoir estimer la qualité d’un code ainsi en première lecture. C’est la conclusion d’un papier anglais de 2010.

🤖 Un nommage obscur n’est pas difficile à détecter, même par une machine : encodage, identifiants trop courts ou trop longs, abbréviations, casse dissonnante, etc. La plupart des analyseurs statiques ont largement automatisé cela. L’oeil humain vient analyser en dernier lieu quand la machine a dégrossi le travail. L’équipe de chercheurs a procédé ainsi pour caractériser un nommage défaillant dans son travail.

👎 La qualité logicielle est plus difficile à quantifier : les chercheurs ont choisi la très décriée complexité cyclomatique, ainsi qu’un score FindBugs. C’est rapide et facile à obtenir, mais cela affaibit grandement le papier.

⚠️ Enfin il est important de noter que seuls des projets open-source ont été inclus dans les données de l’étude. Les chercheurs avertissent que les résultats (confidentiels) obtenus avec des projets commerciaux semblent ne pas suivre du tout la même tendance. Prudence, donc !

SOURCE

Butler, Simon; Wermelinger, Michel; Yu, Yijun and Sharp, Helen (2010). Exploring the Influence of Identifier Names on Code Quality: An empirical study. In: 14th European Conference on Software Maintenance and Reengineering, 15-18 Mar 2010, Madrid, Spain, pp. 156–165. DOI:10.1109/CSMR.2010.27

📄 Lien public

DOIs:

10.1109/CSMR.2010.27

Factors Affecting Software Development Productivity: An empirical study 🔗

🧑💼 Management

·

🧮 Méthodes de développement

·

#️⃣ Façonnage de code

📊 Comment augmenter la productivité des développeurs ? D’abord en ne se trompant pas de métrique : mesurer le nombre de lignes de code vous emmène dans une direction désastreuse, surtout à l’heure de ChatGPT. La productivité, c’est la valeur livrée dans une période de temps. Les auteurs de cette revue de littérature ont pris soin d’écarter les papiers basés sur le nombre de lignes de code, pour en retenir 57.

🔨 Les résultats ne surprendront pas les développeurs, mais peuvent se révéler utiles pour servir d’argument d’autorité face à un manager récalcitrant. D’abord il y a les facteurs humains : experience, compétences, faible turnover et facilités à communiquer en tête. Viennent ensuite les caractéristiques du produit : faible complexité, langage de haut-niveau, difficulté et nombre des exigences.

❗ C’est au niveau de l’organisation que l’on trouve les résultats les moins intuitifs : la présence d’une culture du postmortem et de la métrique, l’élimination du rework et la structuration en petites équipes sont en bonne place. La réutilisation des composants, l’usage d’outils et le temps passé à s’entraîner sont également pointés comme des facteurs de productivité.

👉 La liste présentée ici n’est pas exhaustive, il faut lire le papier pour en avoir la version complète.

SOURCE

Edna Dias Canedo and Giovanni Almeida Santos. 2019. Factors Affecting Software Development Productivity: An empirical study. In Proceedings of the XXXIII Brazilian Symposium on Software Engineering (SBES ‘19). Association for Computing Machinery, New York, NY, USA, 307–316. DOI:10.1145/3350768.3352491

DOIs:

10.1145/3350768.3352491

Regarding the Impact of Code Smells on the Energy Efficiency of Different Computer Languages 🔗

#️⃣ Façonnage de code

·

🦨 Code Smells

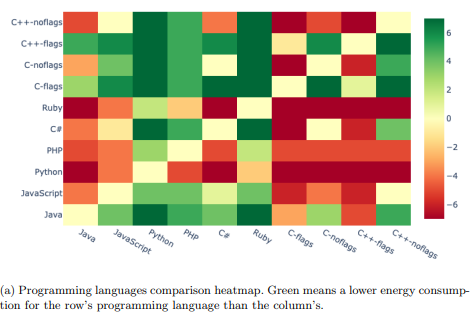

🦨 Les odeurs du code ne sont pas seulement un gâchis de temps de cerveau : la consommation d’énergie augmente également ! C’est le résultat obtenu par un étudiant néerlandais sur plusieurs langages.

🍝 L’étude présente néanmoins de fortes limites : certains langages ne parviennent pas à rejeter l’hypothèse nulle sur tous les problèmes testés et pire, seule l’odeur “Long Function” a été évaluée.

🌍 Ce papier a un mérite : il ouvre un champ de recherche entier à ceux qui veulent savoir si les odeurs du code ne seraient pas aussi des plaies environnementales.

SOURCE

Van Oostveen Sander, Regarding the Impact of Code Smells on the Energy Efficiency of Different Computer Languages, University of Amsterdam, 2020

Energy efficiency: a new concern for application software developers 🔗

🧮 Méthodes de développement

·

👌 Qualité logicielle

🔋 Avant 2012, la consommation d’énergie n’intéressait personne, certainement pas les chercheurs. Depuis ? Les applications mobiles ont mis cette question au centre, bien plus que les préoccupations écologiques. Une application mobile moderne ne consomme rien car elle balance tous les calculs lourds sur un cloud supposé vertueux. L’idéologie californienne de Barbrook, toujours elle.

👿 La plupart des développeurs ne sont pas des salauds, mais manquent de connaissances et d’outils sur ce sujet ! Peu savent distinguer puissance et énergie, les outils de mesure de consommation sont peu répandus et ne conseillent en aucun cas sur les mesures à prendre pour économiser l’énergie. L’outillage de haut-niveau manque, les développeurs en sont réduits aux modifications hasardeuses de bas-niveau, très corrélées au nombre de défauts.

✅ Les auteurs dressent ensuite un état de l’art qui n’a pas vieilli dans ses grandes lignes, le papier date de 2017.

SOURCE

Pinto, Gustavo & Castor, Fernando. (2017). Energy efficiency: A new concern for application software developers. Communications of the ACM. 60. 68-75. DOI:10.1145/3154384.

📄 Lien public

DOIs:

10.1145/3154384

The World Wide Web: Past, Present and Future 🔗

👔 Avis d'expert

💣 En 1996, l’architecte du World Wide Web, Tim Berners-Lee, annonçait les effets potentiels de celui-ci sur le monde. Appauvrissement de la diversité culturelle par l’abaissement des barrières géographiques au profit d’une soupe américanoïde; Transfert de l’autorité parentale à l’Etat, seul capable de contrôler le contenu visionné par les enfants; Ghettoïsation de la vie démocratique en clans radicalisés et irréconciliables;

🧙♂️ Il n’était nullement prophète, mais architecte. L’architecture du Web est pensée pour répondre ensemble à des exigences précises, définies dès son origine. Ces exigences sont démentes : le Web doit permettre de relier arbitrairement deux ressources à travers le monde, indépendamment des technologies qui les servent, sans format contrait, de manière décentralisée et suffisamment ergonomique pour impliquer des non-techniciens dans l’ajout de contenu. Berners-Lee n’est pas le premier à essayer de faire advenir le rêve de Vanevar Bush et de toute une génération, mais il sera le premier à y arriver.

🌐 Face à des exigences, le travail de l’architecte est de définir des contraintes, qui devront être suivies par les implémentateurs. La première contrainte est l’indépendance des spécifications : tout doit cohabiter sur le web, l’ancien comme le neuf afin qu’il n’ait pas besoin d’être “redémarré” pour évoluer. La seconde est la capacité de référencer n’importe quoi sur un autre serveur, sans son consentement (ce qui a le défaut de permettre les liens morts). La troisième est la possibilité de négocier le contenu préalablement à l’échange, afin que client et serveur trouvent un format commun.

🦯 Ces contraintes remplissent les exigences, mais sans garantir l’absence d’effets de bord. Le déploiement d’un tel système au niveau mondial a eu les effets décrits au début de cet article. Fallait-il créer le Web ? Face à ces risques, Berners-Lee répondit par le techno-solutionnisme : nous trouverons bien un moyen technique de rendre le Web éthique. L’echec de PICS sert d’invalidation de cette idée.

SOURCE

Berners-Lee Tim, The World Wide Web: Past, Present and Future, August 1996, W3.org

📄 Lien public

How reuse influences productivity in object-oriented systems 🔗

👌 Qualité logicielle

📦 Utiliser une bibliothèque plutôt que de développer from scratch permet une plus grande productivité, avec moins de défauts, de bugs et de temps passé à corriger ces derniers. Tout cela bien entendu, si les bibliothèques sélectionnées sont pertinentes pour le besoin.

🧑🎓 Ces résultats ont été obtenus sur des étudiants, ce qui peut biaiser les résultats, de l’aveu même des auteurs. Les bibliothèques utilisées ont probablement été développées par plus senior qu’eux.

SOURCE

Basili, Victor R., Lionel Claude Briand and Walcélio L. Melo. “How reuse influences productivity in object-oriented systems.” Commun. ACM 39 (1996): 104-116. DOI:10.1145/236156.236184

📄 Lien public

DOIs:

10.1145/236156.236184

Classifying Software Changes: Clean or Buggy ? 🔗

🧪 Tests

🔮 Prenez un commit, il serait miraculeux d’avoir un “oracle” capable de dire avec précision les chances d’y trouver des bugs, exactement comme les indices au démineur. C’est possible grâce au Machine Learning, au moins en conditions de laboratoire.

🤖 Il faut pour cela entraîner un modèle, le classificateur, à partir des changements sur un VCS. La procédure exacte est détaillée dans le papier. Le modèle est évalué en vérifiant si de véritables bugs, présents puis corrigés sur des projets open-source, sont détectés.

🛠️ J’ignore si des outils contemporains utilisent de telles techniques. L’article date de 2008, bien avant la hype sur l’IA.

SOURCE

Kim, Sunghun, E. James Whitehead and Yi Zhang. “Classifying Software Changes: Clean or Buggy?” IEEE Transactions on Software Engineering 34 (2008): 181-196.

📄 Lien public

DOIs:

10.1109/TSE.2007.70773

Random Test Run Length and Effectiveness 🔗

🧪 Tests

🎲 Les tests aléatoires fonctionnent comme un puits de pétrole. Les premiers runs ont peut de chance de remonter des bugs. Persévérez, ils viendront, puis se raréfieront progressivement. A partir d’un certain point, le temps passé pour détecter un nouveau bug rendra la démarche totalement inefficiente budgétairement.

📈 Le nombre de runs avant d’atteindre ce “pic” dépend du projet, il est donc conseillé de mesurer le nombre de défauts détectés par heure lorsque l’on lance des tests aléatoires. Le pic se verra sur la courbe ainsi tracée.

SOURCE

Andrews, James & Groce, Alex & Weston, Melissa & Xu, Ru-Gang. (2008). Random Test Run Length and Effectiveness. 19-28. DOI:10.1109/ASE.2008.12.

📄 Lien public

DOIs:

10.1109/ASE.2008.12

Empirical investigation towards the effectiveness of Test First programming 🔗

🧪 Tests

🐌 Test-First, dont TDD fait partie, ne rend pas les développeurs plus productifs que Test-Last ! Pire, les praticiens de Test-First passent plus de temps à tester, pour une qualité visible identique. Le temps passé à tester est en revanche du temps en moins passé sur le code.

⚠️ TDD est-il à ranger au placard ? Pas si vite. D’abord, l’étude note que les groupes TDD n’avaient pas une forte expérience et ont passé autant de temps à apprendre la méthode qu’ils en ont passé à pratiquer. Fait connu des praticiens de TDD : au début c’est laborieux. Second biais : le groupe TDD n’effectuait que des tests unitaires. Or, il est plutôt recommandé actuellement l’outside-in TDD, soit TDD pour les tests fonctionnels.

🕰️ L’étude date de 2009, ce qui explique bien des choses. Elle mériterait d’être reproduite 15 ans après.

SOURCE

Huang, Liang & Holcombe, M.. (2009). Empirical investigation towards the effectiveness of Test First programming. Information & Software Technology. 51. 182-194. DOI:10.1016/j.infsof.2008.03.007.

📄 Lien public

DOIs:

10.1016/j.infsof.2008.03.007

What Types of Defects Are Really Discovered in Code Reviews ? 🔗

🧮 Méthodes de développement

👀 Les revues de code sont complémentaires aux tests. Les tests sont incapables de repérer le manque d’évolutivité du code, les revues très peu performantes pour remonter les défauts fonctionnels.

🤖 Mieux, les revues de code sont complémentaires aux outils comme les linters ou les analyseurs statiques, à condition de faire passer ceux-ci avant la review pour éviter de longs débats inutiles.

🧑🎓 L’étude démontre également que les étudiants et les professionnels obtiennent des résultats comparables lors des code reviews, ce qui peut permettre de valider certaines études similaires uniquement effectuées sur des étudiants.

🤝 Ce que l’étude ne vérifie pas, c’est si le pair programming, véritable revue de code en live, obtient des résultats similaires.

SOURCE

Mika Mäntylä and Casper Lassenius. “What Types of Defects Are Really Discovered in Code Reviews?” IEEE Transactions on Software Engineering 35 (2009): 430-448. DOI:10.1109/TSE.2008.71

📄 Lien public

DOIs:

10.1109/TSE.2008.71

Using Program Slicing in Software Maintenance 🔗

🧪 Tests

👎 Pour éviter les régressions, nous utilisons habituellement les tests. Même lorsqu’ils existent et sont de qualité, il s’agit rarement d’une assurance tous-risques. D’autres techniques peuvent les compléter pour s’assurer de ne rien casser. L’une d’elle est le slicing.

🍕 Une slice est une tranche de programme elle-même exécutable. Prenez un programme. Faites-le tourner avec des valeurs particulières jusqu’à un point d’arrêt. Supprimez tout le code qui n’a pas eu d’influence sur l’exécution. Vous avez une slice.

🧑🔬 Déjà utilisées en débogage, pour restreindre l’endroit du code où chercher les problèmes, les slices peuvent aussi être utilisées pour s’assurer de ne pas introduire de régressions lors d’une modification. La technique se fait en construisant 2 slices liées mathématiquement : la décomposition et son complément. La logique de construction de ces 2 slices assez complexe et plutôt réservée aux développeurs d’outils.

✅ Ce binôme de slices permet de prédire si une insertion ou une suppression de code aura des effets de bord. Le développeur effectue ses modifications, puis regénère à nouveau les deux slices. Si les compléments sont identiques avant et après les modifications, il est mathématiquement sûr qu’aucune régression n’a été introduite. Attention cependant : cela n’indique en rien que le changement lui-même est correct.

🔬 J’ignore si ce papier a eu une postérité, cela fera l’objet d’une recherche à part, tant l’idée a l’air novatrice.

SOURCE

Gallagher, Keith & Lyle, James. (1991). Using Program Slicing In Software Maintenance. Software Engineering, IEEE Transactions on. 17. 751-761. DOI:10.1109/32.83912

📄 Lien public

DOIs:

10.1109/32.83912

Mixin-Based Inheritance 🔗

🔣 Science des Langages